机器内容产出火爆出圈,但是否符合人类价值观就是其核心问题

ChatGPT突然的火爆出圈,让智能内容产出成了一种可能。可是我们在接受着这样一种现状的同时,也需要审视这一现状背后更深层次的问题。

比如,ChatGPT提供的内容并不一定完全符合我们人类的习惯,甚至也有很多内容,存在着巨大的误解和偏见,对于我们中国读者人来说,用ChatGPT可以看到很多奇奇怪怪的答案,一看就能够了解它背后的价值观,有经验的人也能够一眼看到这些内容来自于人工智能,和真人创作是有差别的。

为什么会这样呢?其实智能内容产出依然需要的是机器学习,但机器学习本身就有着非常多不确定性,有着很多依然需要我们解决的问题。

机器学习并不是一种完全自主的学习,和我们人类的学习方式也有着本质的差别,它依然是基于大量信息的基础上,依靠算法来完成。

这其中有着两个关键词,分别是信息和算法,但人工智能的信息和算法也依然是人为操控的,因为人为操控所属的不同文化氛围和个人喜好,所选择的不同信息、不同算法,也就让机器学习有了完全不同的表现形式,也就会有偏见。

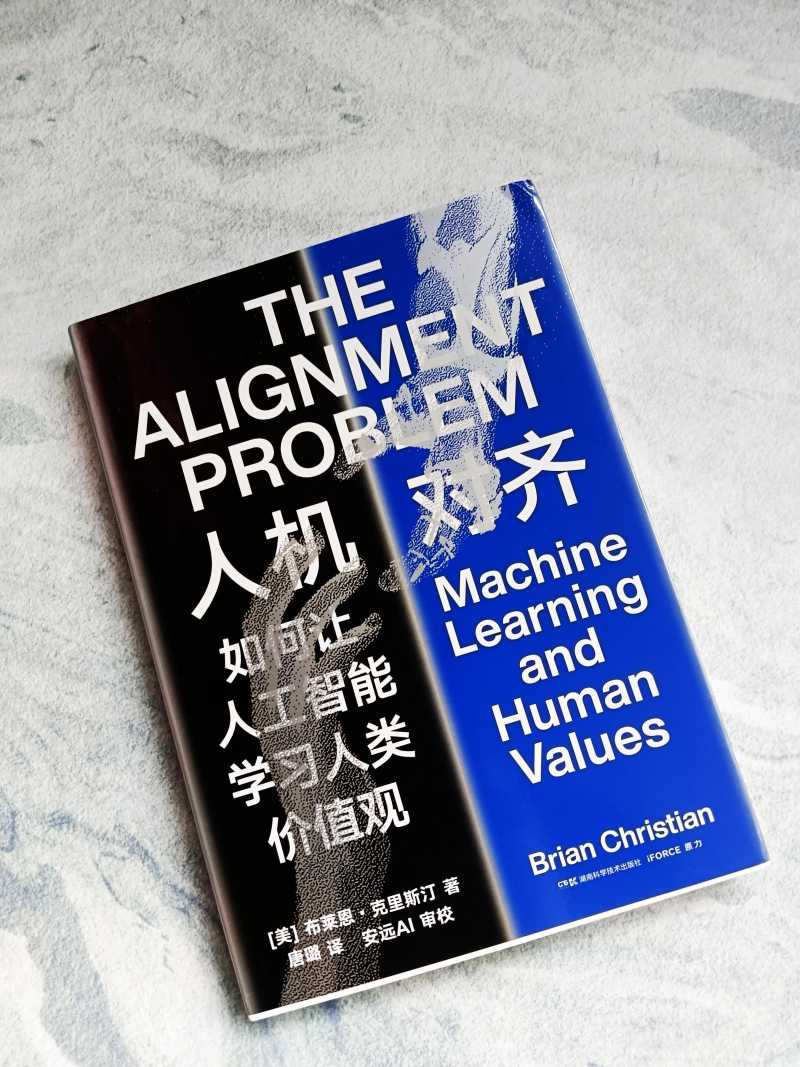

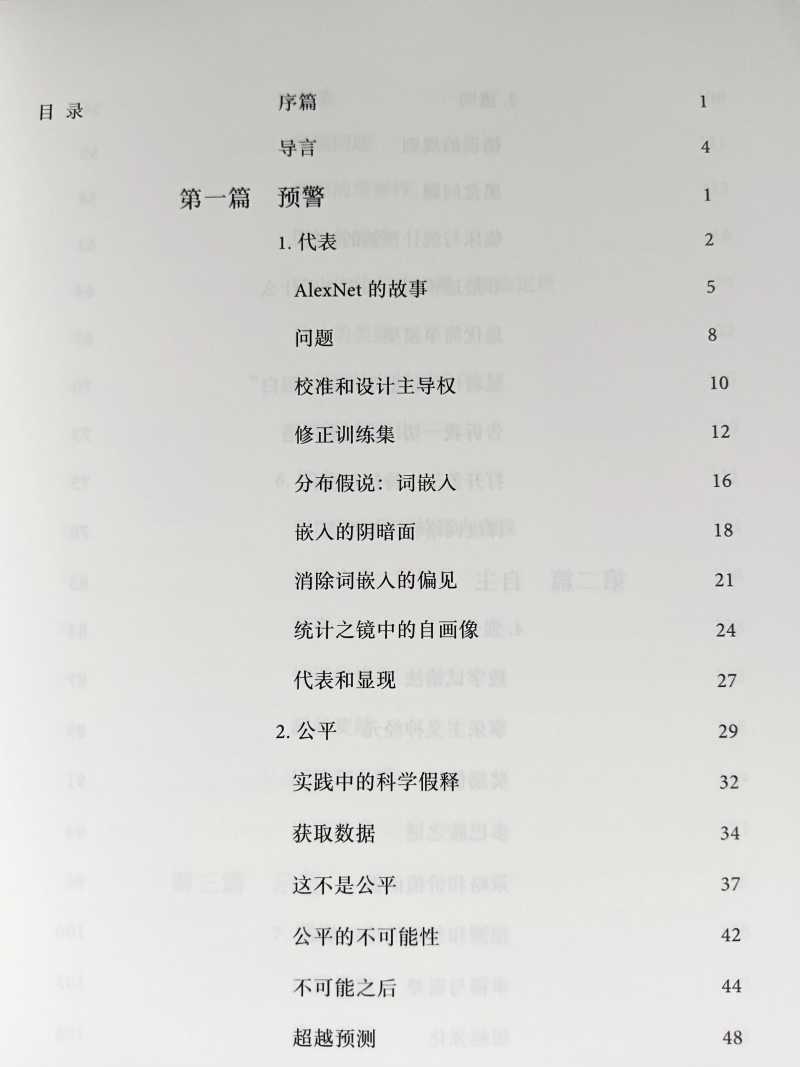

布莱恩·克里斯汀,畅销书作家,他的《算法之美》入选了亚马逊年度最佳科学书籍和MIT技术评论年度书籍;《人机大战》也是畅销书,这都是他关注于人与机械之间的相互关系而产生的思考。

现在他相应的思考依然在继续,因此也就创作了这样一本《人机对齐:如何让人工智能学习人类价值观》,关注于人工思考的最后阵地,机器学习和人类价值观之间的相应匹配,也就被作者形象的称为“人机对齐”问题。

其实这也是基于现实之中人工智能所表现出来的价值观偏见得出来的结论。偏见肯定是人与机器共有,而我们人类的价值观受到道德制约,可以及时做出调整,但机器却无法做到,这就让这种价值观倾向在人工智能领域表现的更加重要,也更具风险。

基于机器学习的相关理论,怎样来改善这一缺陷,怎样完善机器学习最重要的一步呢?克里斯汀精练地描绘了机器学习的发展史,并且深入科研一线同科学家对话,准确呈现了机器学习前沿的进展,并给出很多切实可行的建议。

其实人机对齐问题,说到底依然是人类自身的问题,理应让我们人类在其中扮演重要的角色。就像作者所说“对其问题还是一面镜子,将人类自身的偏见和盲点暴露出来,让我们看清自己从未阐明的假设和经常自相矛盾的目标”。

那么在进行完善机器学习的同时,我们也需要不断的审视自身,只有我们自身能够有着广阔的人类视野,不带偏见的把信息和算法传递给机器,机器才能给出不带偏见的程序,而这是一个任重而道远的过程。人类的文化也在时刻的变更之中,但相信通过作者的这一系统性审视,一定能够让我们看到一条更为广阔的道路。#人机交互##人工智能##

大家都在看

-

中外交流丨镜头下的沙海新绿——从图片展上的照片看新疆带给世界的治沙灵感 “大美新疆铸辉煌——纪念新疆维吾尔自治区成立70周年”主题图片展12月10日在哈萨克斯坦国家博物馆拉开帷幕。哈国家博物馆馆长阿布德哈利乌勒致辞说,本次图片展在哈萨克斯坦成功开幕,是两国人民民心相亲、精神与智 ... 机械之最12-17

-

中国玩具如何“玩转”全球大市场? 原标题:科技范儿、文化范儿、绿色范儿——中国玩具“玩转”全球大市场在义乌全球数贸中心,外国客商与经营户洽谈采购事宜。王怿杰摄在义乌全球数贸中心,商家展示可变形智能玩具。王怿杰摄广东新佳奇科技有限公司工 ... 机械之最12-17

-

专科生逆袭!2026机械专业必考8大黄金证书,好就业薪资高! 各位机械专业的大专同学们,是否在思考如何提升竞争力,获得高薪工作?答案就在考取高含金量证书。在智能制造时代,“技能+证书”是你最硬的敲门砖。2026年大专机械设计与制造专业最值得投资的8大证书,能直接助力你 ... 机械之最12-17

-

在寒风中飘落的树叶是麻烦还是资源?每年520万吨枯枝落叶去哪了 深秋初冬,落叶玩家“卷”了起来:他们收集好看的叶子,亲手做成一顶魔法帽、一件披风或是扎成一把花束,用自己的巧思延长落叶的生命。京城的树郁郁葱葱。统计显示,每年的枯枝和落叶达到了惊人的520万吨,而且仍在 ... 机械之最12-17

-

跃升48位!太重再次荣登“中国机械500强”榜单 近日,2025年中国机械500强研究报告发布会暨中机企协业务总部启用仪式圆满落幕。太重凭借优异表现和雄厚实力,再次荣登“2025中国机械500强”与“2025中国机械500大”双榜单,其中“2025中国机械500强”较去年跃升48 ... 机械之最12-17

-

Anthropic重磅新研究:当AI采访了1250人,它看见了人类的“职业软肋” AI不仅能回答问题,还能采访人类了。Anthropic让模型与1250名真实用户深度对话,自动写提纲、追问、做聚类分析,最后画出一张「人类情绪雷达图」。这一次,人类成了AI的研究对象。很难想象,有一天AI真的开始采访人 ... 机械之最12-16

-

世界五大军事家第5名:成吉思汗 —— 冷兵器时代最恐怖的战争机器 图片来源于网络如果战争是一门关于破坏与征服的极端艺术,那么成吉思汗无疑是这门艺术史上最伟大的工程师。他并非仅仅是一位骑兵统帅,而是一位颠覆了草原规则、重塑了战争逻辑的帝国缔造者。他的蒙古军团,是中世纪 ... 机械之最12-16

-

“十四五”期间 太原市强化企业创新主体地位 激发创新活力 创新驱动发展,技术引领未来。在科技竞争日益激烈的背景下,作为市场主体的企业,创新能力已成为衡量企业乃至城市核心竞争力的关键指标。 “十四五”期间,我市强化企业创新主体地位,推进企业与国内大院大所 ... 机械之最12-16

-

理科专业解读一:从学业到就业,一文搞懂机械类专业! 机械类专业,由于其布点院校多、招生规模大、社会应用性强、就业前景广阔,成为无数考生与家庭青睐的务实选择。因此几乎每年都是高考志愿填报的“重头戏”。本期飞翔老师将带大家详细盘点和梳理机械大类下各专业的培 ... 机械之最12-15

-

大专生逆袭!2026机械设计与制造专业必考8大证书 各位机械专业的同学,你是否担心专科学历在求职时缺乏竞争力?是否觉得传统机械行业薪资天花板触手可及?在智能制造与工业4.0席卷全球的今天,仅凭一张毕业证早已不够。精准考取高含金量证书,是你打破学历局限、实 ... 机械之最12-15

相关文章

- 外骨骼机器人“出圈” 行业痛点待解

- 理科专业解读一:从学业到就业,一文搞懂机械类专业!

- 大专生逆袭!2026机械设计与制造专业必考8大证书

- 一级军士长的带兵“三字诀”

- 卖“陪伴”成了生意经?为什么大家都不想独处了

- 四大维度,深度解析2025年中国机械工业500强

- 不要温和地走入AI时代:一封写给青少年的书信

- 太重再次荣登“中国机械500强”榜单

- 马钧:被正史忽略的三国机械之神一具水车救活万民,诸葛亮都叹服

- 《时代》周刊2025年度人物:AI缔造者

- 湖北十堰调查组通报“最忙五人组”事件

- 是必需品还是智商税?空气净化器,有些是不是“吹”过头了?

- AI与人文的“危”与“机”——读《AI时代的文学教育》

- 曾是机械键盘神!2025国产轴崛起,Cherry如今快混不下去

- 网文创作:别被套路给套路了

- 科学需要讲故事——从神经机制到社会信任的深层逻辑

- 玄武岩纤维为何能身价倍增?刘嘉麒院士科普解读

- 地球上千公里深处可能存在重要原始水储库

- 大载重全地形机器人「觉物科技」完成超亿元融资,扎根新疆五年打磨出 “变形金刚”

- 我们需要对AI“好好说话”吗

热门阅读

-

天下第一暗器暴雨梨花针,传说中的唐门暗器做出来了 07-13

-

世界十大大型船舶排名,第一能承重六十万吨! 07-13