GPU时代终结?世界最大芯片加持推理狂飙20倍英伟达H100也被干趴

编辑:桃子 好困

【新智元导读】LLM若以每秒1000+token高速推理,当前最先进的GPU根本无法实现!Cerebras Inference一出世,推理速度赶超英伟达GPU,背靠自研的世界最大芯片加持。而且,还将推理价格打了下来。

LLM若想高速推理,现如今,连GPU都无法满足了?

曾造出世界最大芯片公司Cerebras,刚刚发布了全球最快的AI推理架构——Cerebras Inference。

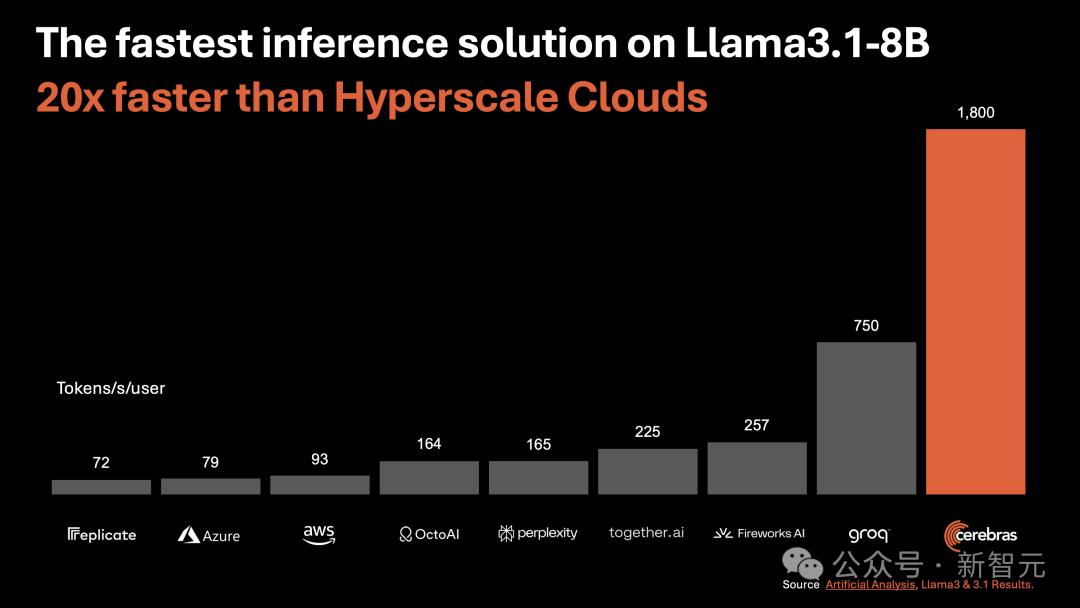

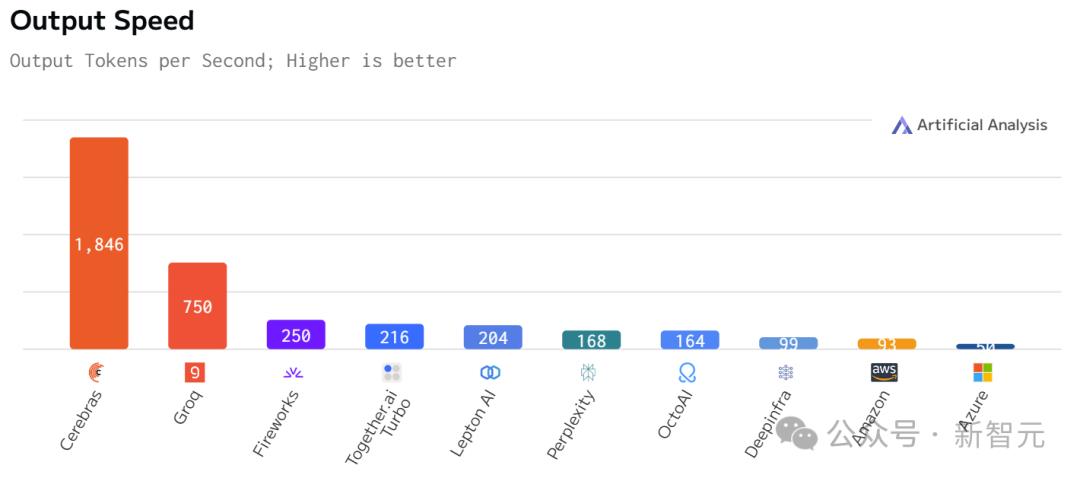

运行Llama3.1 8B时,它能以1800 token/s的速率吐出文字。

不论是总结文档,还是代码生成等任务,响应几乎一闪而过,快到让你不敢相信自己的眼睛。

如下图右所示,以往,微调版Llama3.1 8B推理速度为90 token/s,清晰可见每行文字。

而现在,直接从90 token/s跃升到1800 token/s,相当于从拨号上网迈入了带宽时代。

左边Cerebras Inference下模型的推理速度,只能用「瞬间」、「疯狂」两字形容。

这是什么概念?

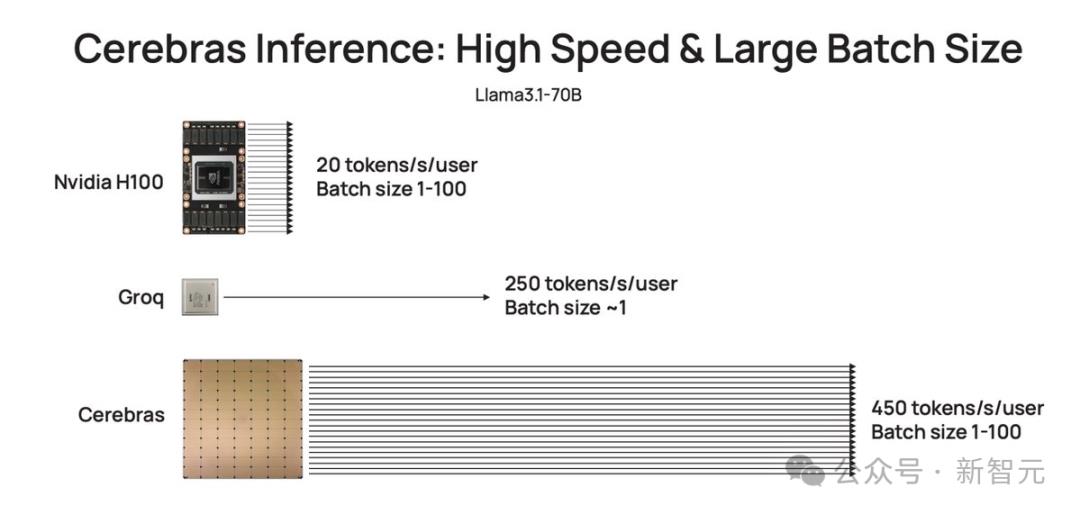

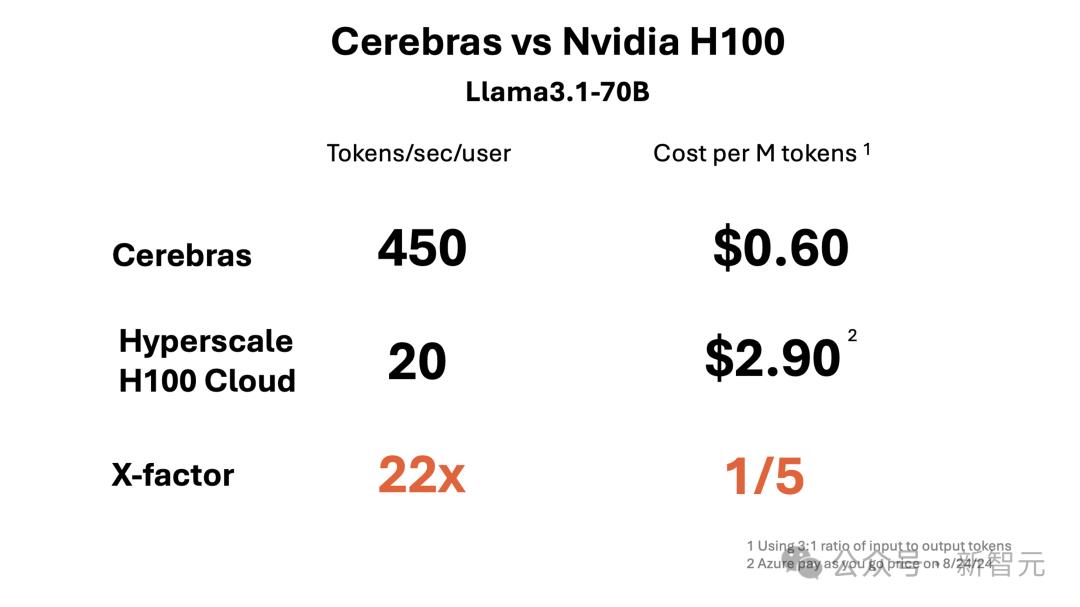

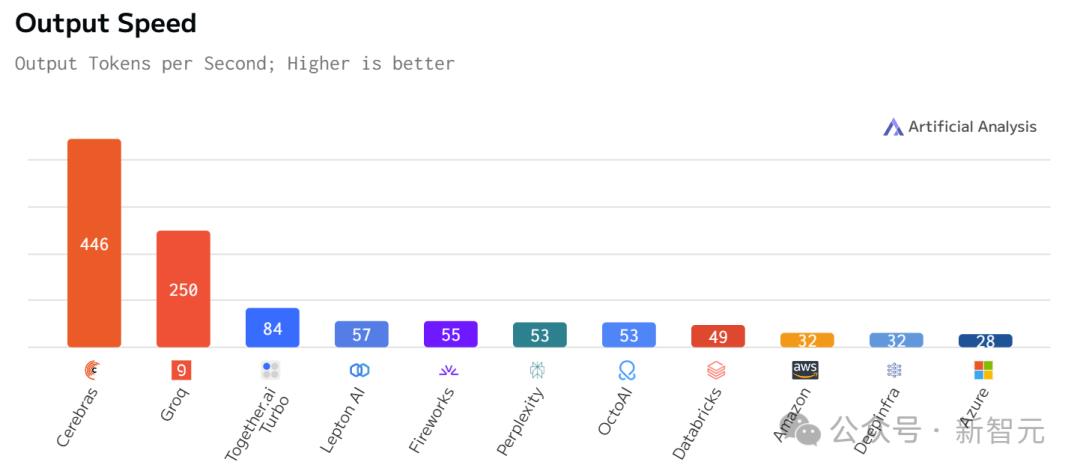

比起英伟达GPU,Cerebras Inference的推理速度快20倍,还要比专用Groq芯片还要快2.4倍。

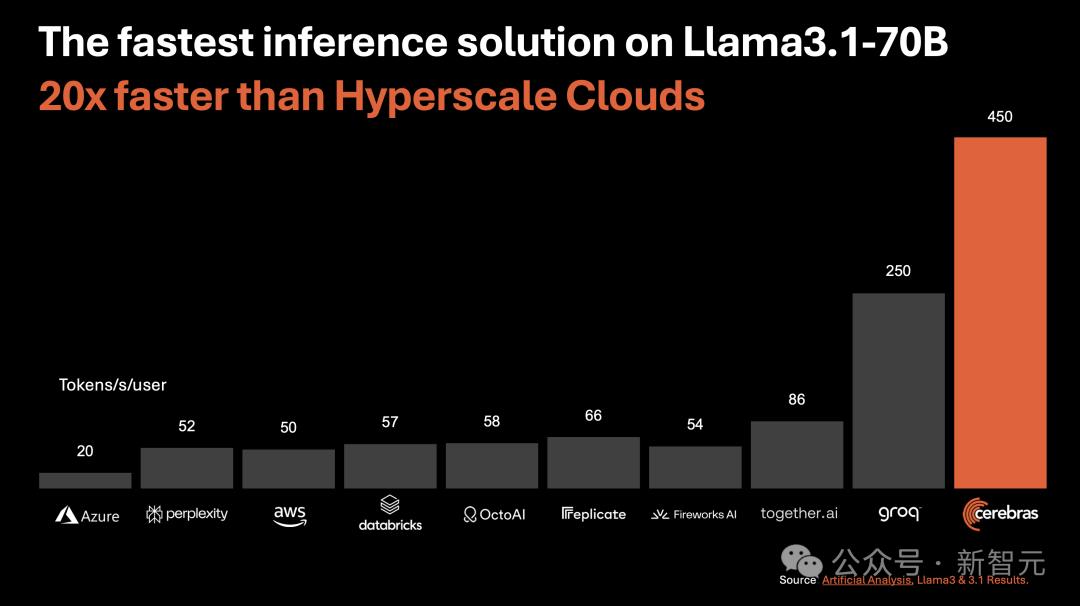

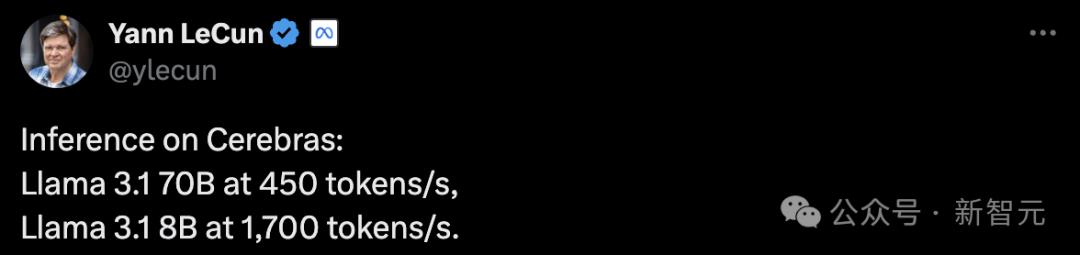

另外,对于70B参数的Llama3.1,可达到450 token/s及时响应。

值得一提的是,Cerebras并没有因为提高LLM的速度,而损失其精度。

测试中,使用的Llama3.1模型皆是采用了Meta原始16位权重,以便确保响应高精度。

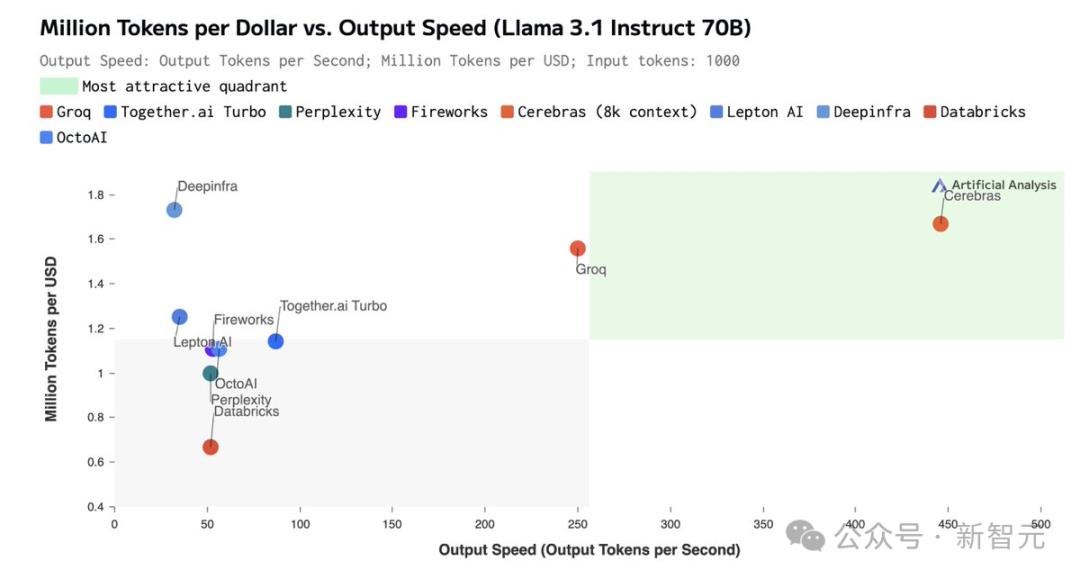

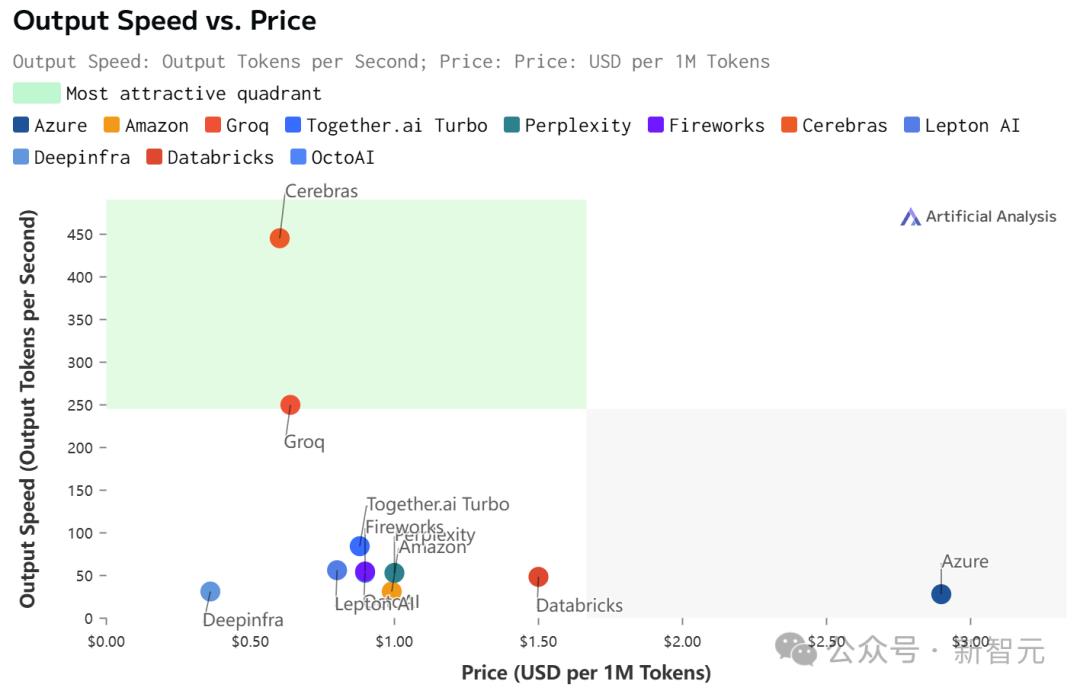

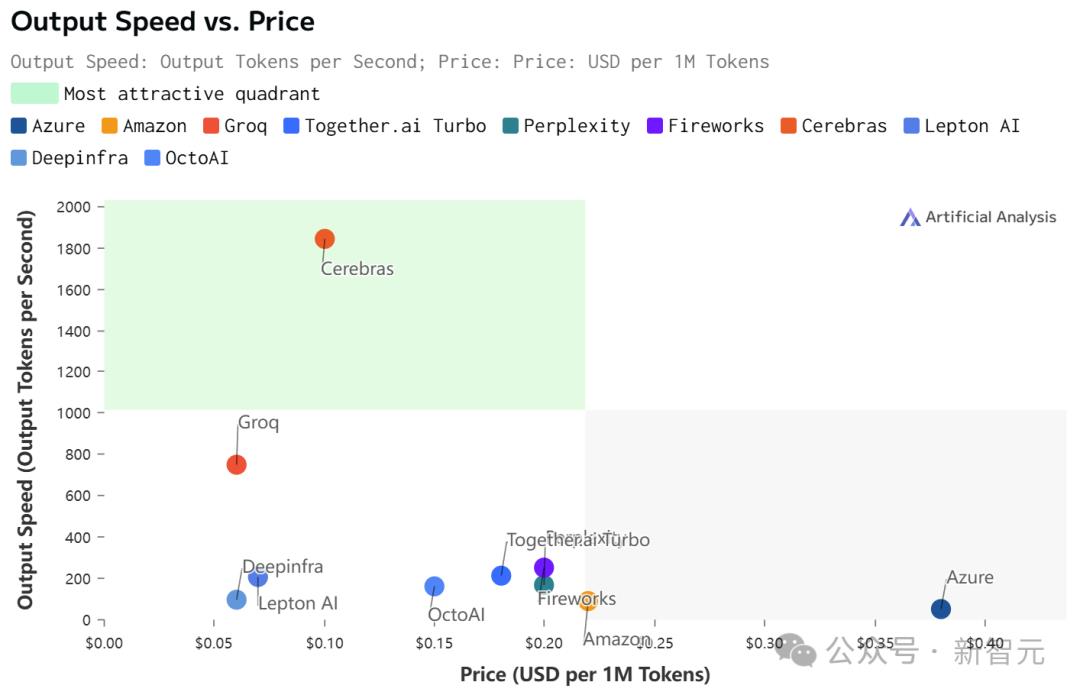

最关键的是,价格还实惠。

根据官方API定价,Llama 3.1 8B每百万token仅需10美分,Llama 3 70B每百万token仅需60美分。

如此之高的性价比,更是打破了业界纪录——

不仅远超之前的保持者Groq,而且和其他平台相比,甚至是隔「坐标轴」相望了。

Artificial Analysis

正是因为Cerebras Inference背后,是由自研的第三代芯片Wafer Scale Engine助力,才得以1/5价格快速推理Llama3.1。

看到自家模型推理如此神速,LeCun、Pytorch之父纷纷动手转发起来。

还有网友看后表示,我想要!

推理很慢,英伟达GPU也不中用?

为什么LLM的响应,就像拨号上网加载网页一样,一个字一个字慢慢地吐出?

关键原因所在,大模型自身的顺序特性,以及需要大量的GPU内存和带宽。

由于GPU的内存带宽限制,如今推理速度为每秒几十个token,而不是数千个。

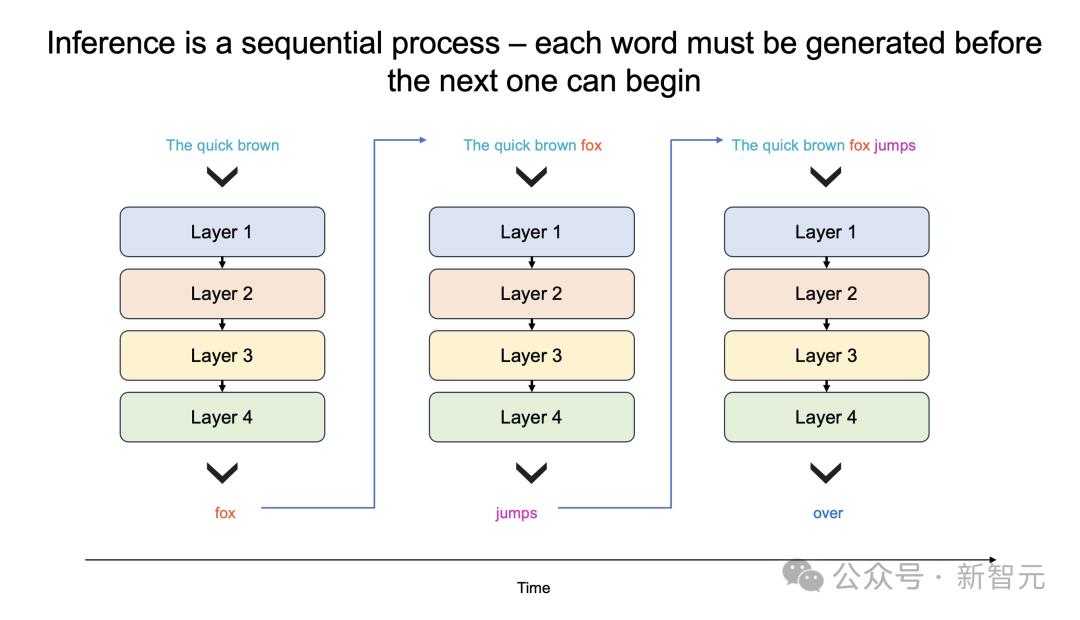

更进一步说,大模型每个生成的单词,都必须通过整个模型进行处理,即所有参数必须从内存投入到计算中。

而每生成一个单词,就需要一次处理,以此循环往复。

也就是,生成100个单词需要100次处理,因为「下一词」的预测,皆需要依赖前一个单词,而且这个过程无法并行。

那么,想要每秒生成100个单词,就需要所有模型参数,每秒投入计算100次。

由此,这对GPU内存带宽提出了高要求。

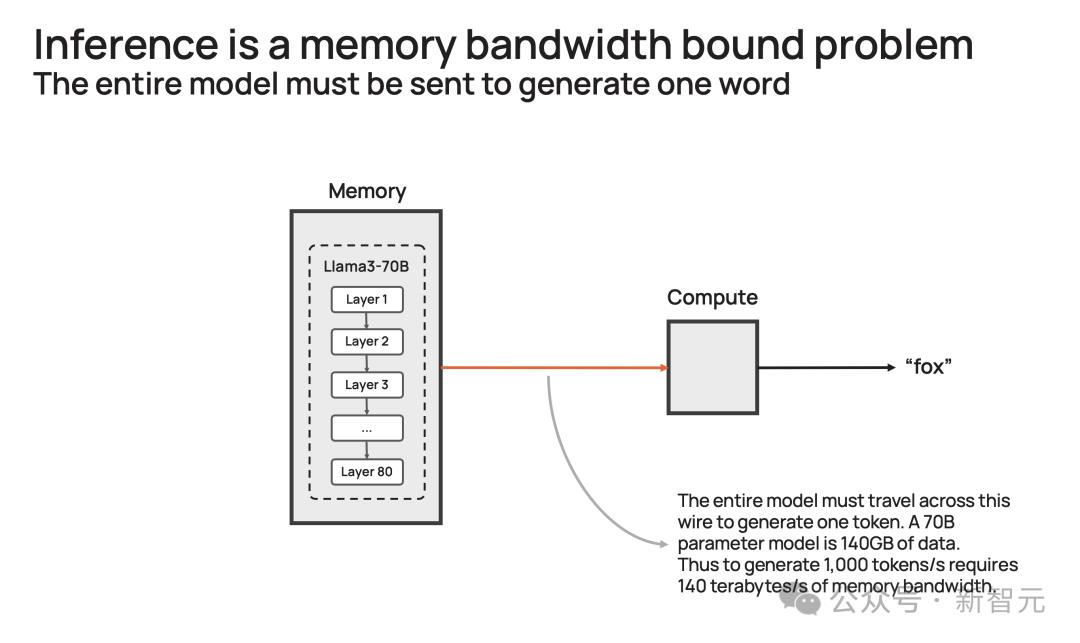

以社区流行的Llama3.1-70B模型为例。

模型有700亿参数,每个参数是16位,需要2字节的存储,那整个模型便需要140GB的内存。

想要模型输出一个token,那700亿参数必须从内存,移动到计算核心,以执行前向推理计算。

由于GPU只有约200MB的片上内存,模型无法存储在芯片。

因此,每次生成的token输出时,需将整个占用140GB内存的模型,完整传输到计算中。

再细算下来,为了实现10 token/s,则需要10*140=1.4 TB/s的内存带宽。

那么,一个H100有3.3 TB/s的内存带宽,足以支持这种缓慢的推理。

而若要实现即时推理,需要达到1000 token/s或140 TB/s,这远远超过任何GPU服务器/系统内存带宽。

或许,你想到了一种「暴力」解决方案,将多个GPU串联搭建DGX系统。

这完全是大错特错,更多的处理器只会增加系统的吞吐量(给出更长响应),并不会加速单个查询的响应时间。

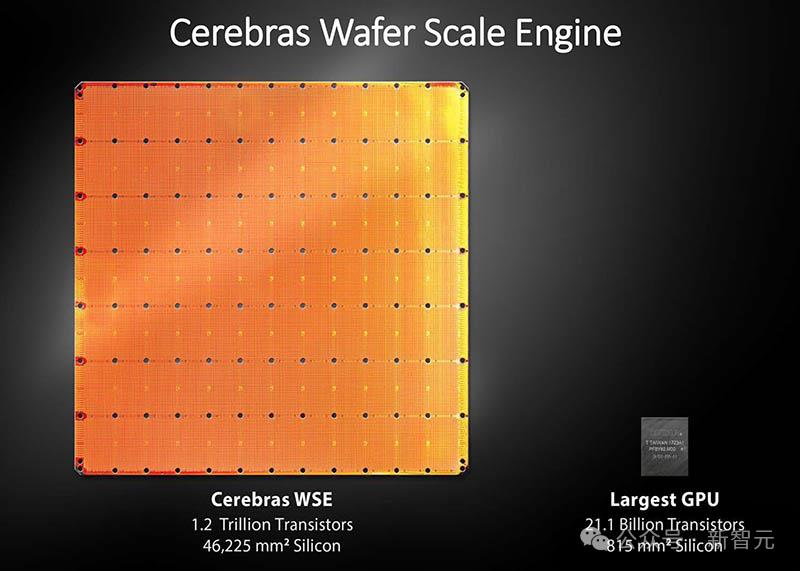

自研世界最大芯片,打破推理想象

那么,Cerebras如何打破这一困局呢?

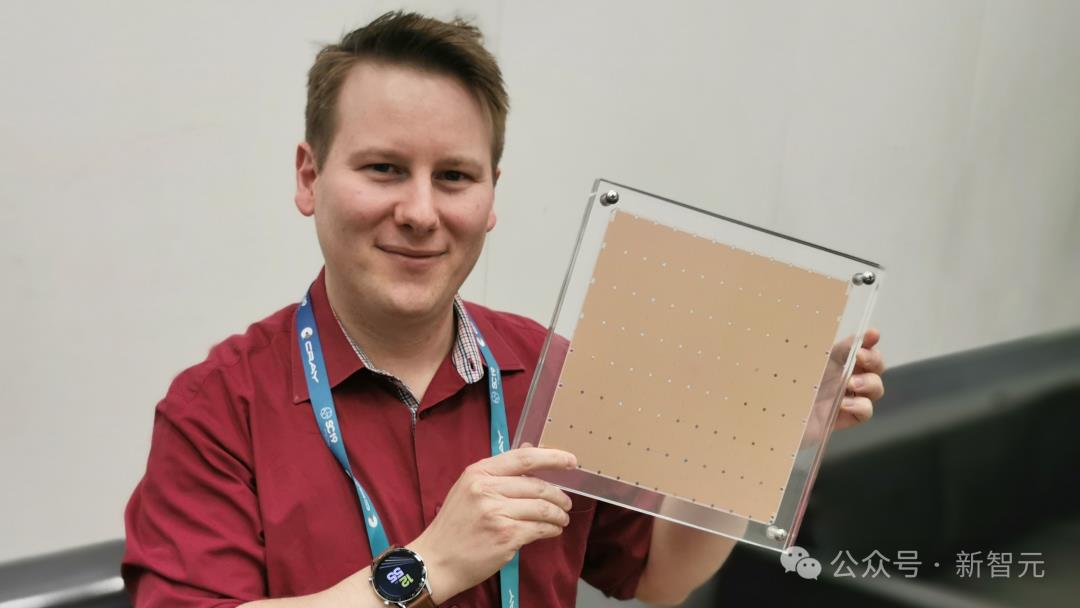

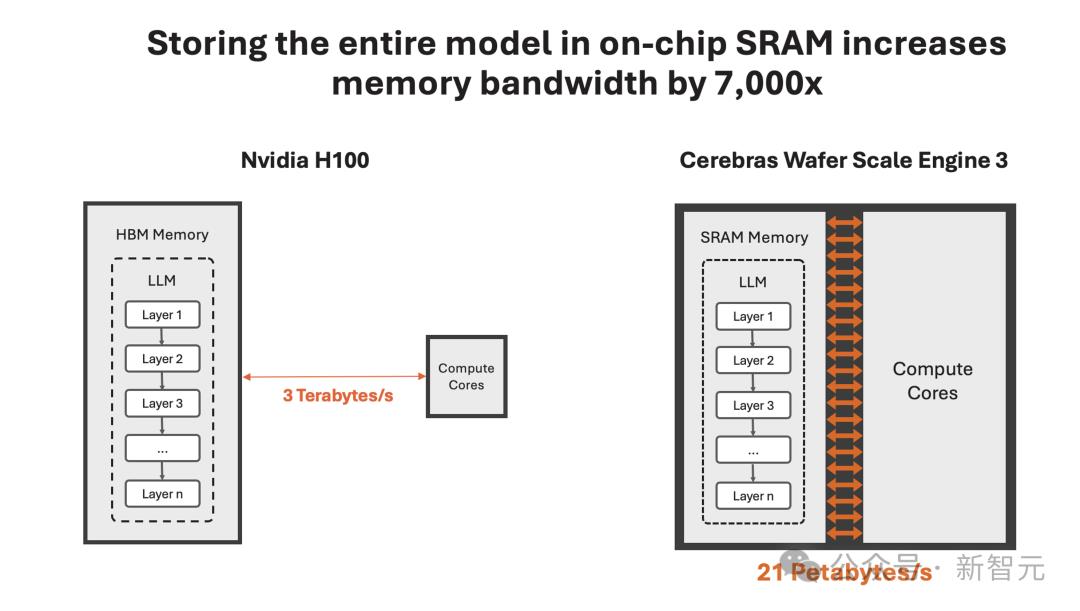

一直以来,这家公司就致力于打造世界上最大芯片,希望将整个模型存储在一个晶片上,以此来解决内存带宽瓶颈。

凭借独特的晶圆设计,WSE-3单个芯片上便集成了44GB SRAM,具备21 PB/s的内存带宽。

单个芯片拥有如此大内存,便消除了对外部内存的需求,以及将外部内存连接到计算的慢速通道。

总的来说,WSE-3的总内存带宽为21PB/s,是H100的7000倍。

它是唯一一款同时具有PB级计算和PB级内存带宽的AI芯片,使其成为高速推理的近乎理想设计。

Cerebras推理不仅速度超快,而且吞吐量巨大。

与小型AI芯片相比,芯片上内存多了约200倍,支持从1-100的批大小,使其在大规模部署时,具有极高的成本效益。

正是有了如此强大的芯片,Cerebras Inference的快速推理得以实现。

它的出现,是为了实现数十亿到万亿参数模型的推理。

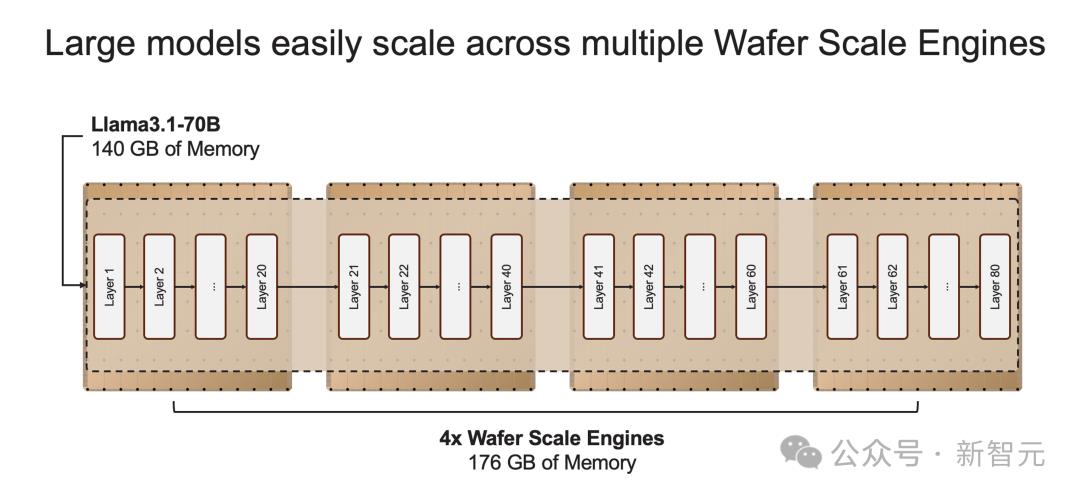

如果模型参数超过单个晶圆的内存容量时,研究人员将在「层边界」将其拆分,并映射到多个CS-3系统上。

20B模型适合单个CS-3,而70B模型则至少需要4个这样的系统。

官方表示,未来几周,将会测试更大参数版本的模型,比如Llama3-405B、Mistral Large。

16位精度,不做取舍

推理速率高,并非在模型权重上,做了取舍。

业界中,一些公司试图将模型权重精度,从16位减少到8位,来克服内存带宽的瓶颈。

这样方法,通常会造成模型精度损失,也就是响应结果的准确性、可靠性不如以前。

Cerebras Inference之所以强就强在了,速率和原始权重,皆要顾及。

正如开篇所述,他们采用了原始16位权重运行了Llama3.1 8B和70B。

通过评估,16位模型准确率比8位模型,高出多达5%。尤其是在,多轮对话、数学和推理任务中表现更好。

最优性价比,百万token免费送

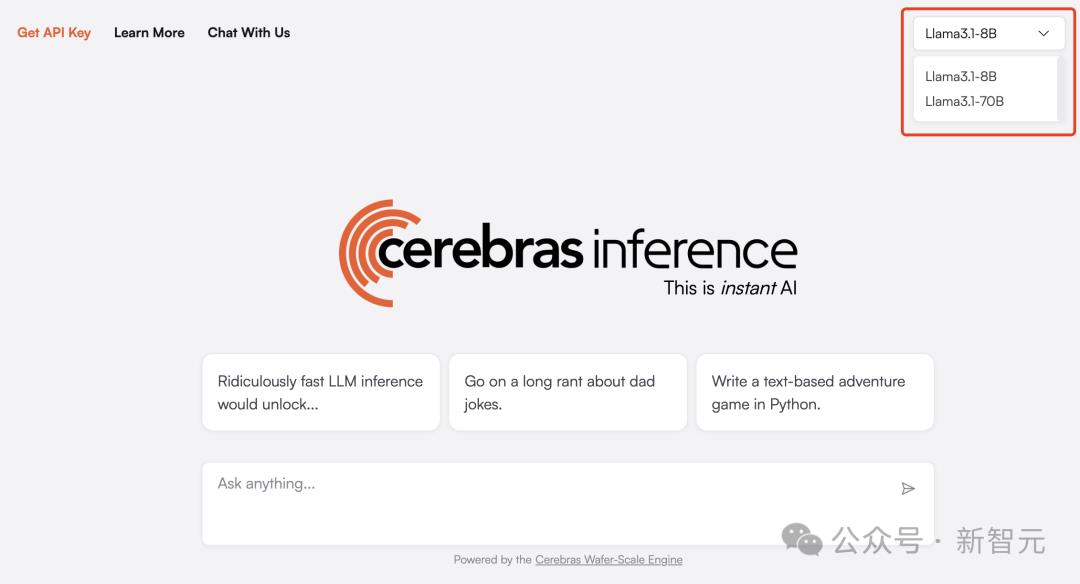

目前,Cerebras Inference可通过聊天平台,以及API访问,任何一个人可随时体验。

体验传送门:https://cerebras.ai/blog/introducing-cerebras-inference-ai-at-instant-speed

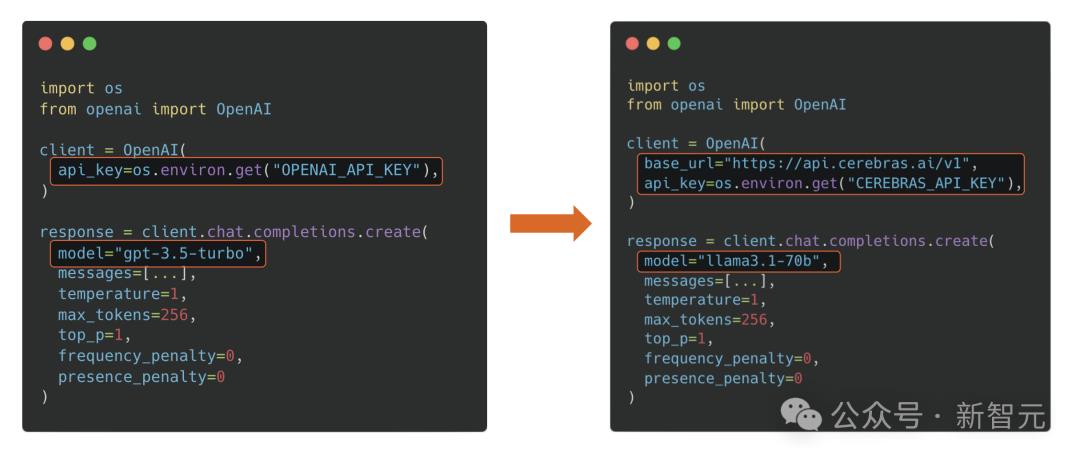

基于熟悉的OpenAI Chat Completions格式,开发者只需更换API密钥即可集成强大的推理功能。

Cerebras Inference API提供最佳的性能、速度、精度和成本组合。

它是唯一能即时运行Llama3.1-70B的方案,可实现450 token/s,同样使用的是原始16位模型权重。

在此,Cerebras送上大福利,每天为开发者们提供100万个免费token。对于大规模部署,其定价只是H100云的一小部分。

首次推出时,Cerebras提供了Llama3.1 8B和70B模型,而且有能力每天为开发者和企业,提供数千亿token。

接下来几周,他们将增加对更大模型的支持,如Llama3 405B、Mistral Large 2。

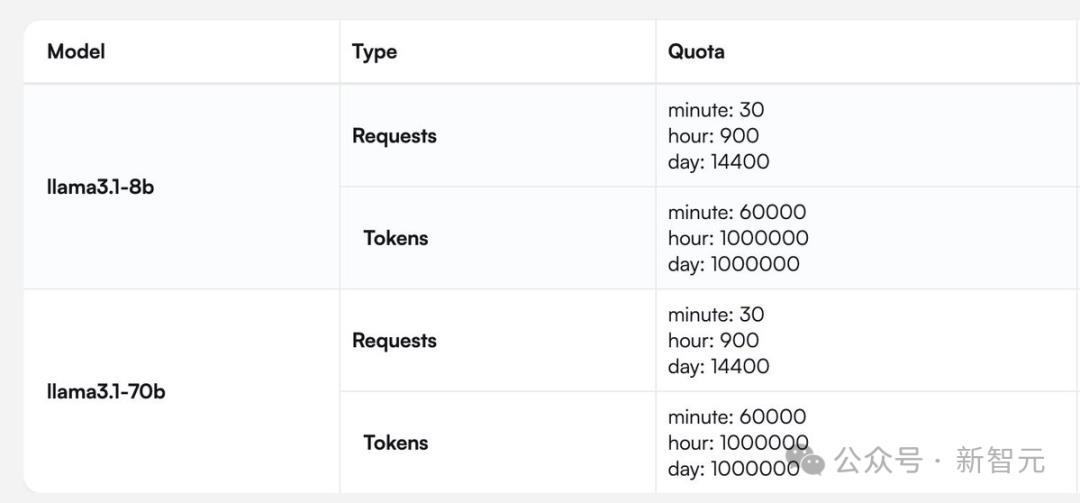

有开发者问道,你们提供的rpm(每分钟请求次数)和tpm(每分钟处理token数)是多少?

Cerebras提供了一张针对Llama 3.1 8B和70B模型完整的请求/token处理数的图。

快速推理,不只为速度

最后,让我们来聊聊,为什么快速推理非常重要?

通常,LLM会即刻输出自己的全部想法,而不考虑最佳答案。而诸如scaffolding(脚手架)这类的新技术,则如同一个深思熟虑的智能体,会在作出决定前探索不同的可能解决方案。

这种「先思考后发言」的方式在代码生成等严苛任务中,可以带来超过10倍的性能提升,从根本上提升了AI模型的智能,且无需额外训练。

但这些技术在运行时,需要多达100倍的token。

因此可见,如果我们能大幅缩短处理时间,那么就可以实现更为复杂的AI工作流程,进而实时增强LLM的智能。

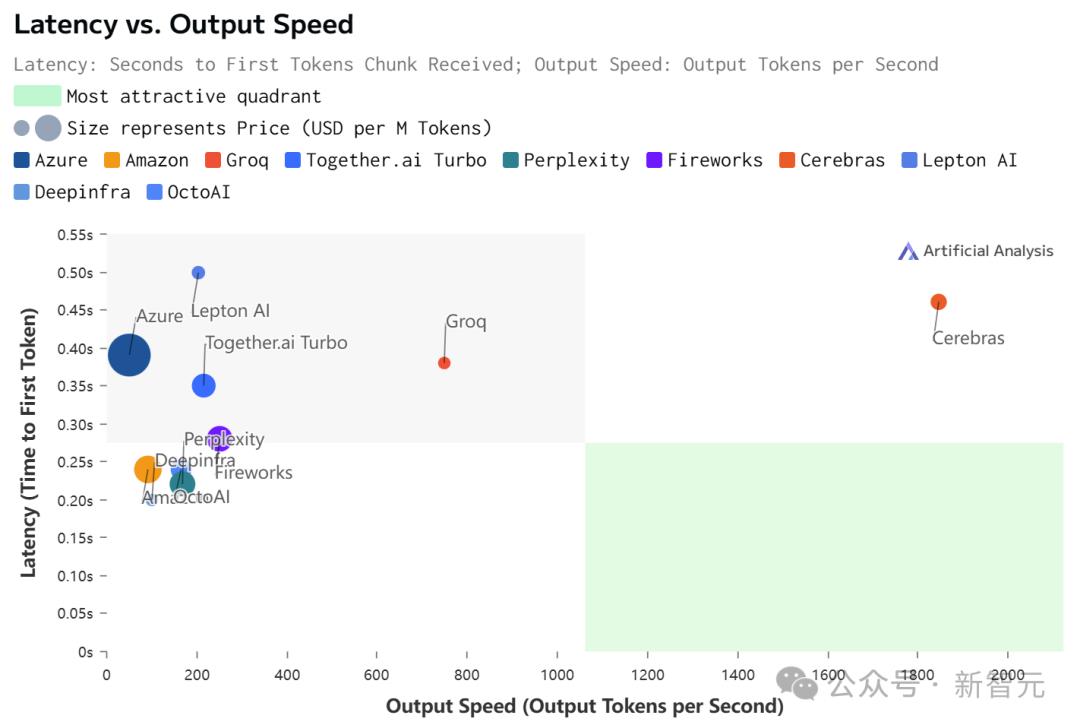

速度爆表,但上下文只有8K

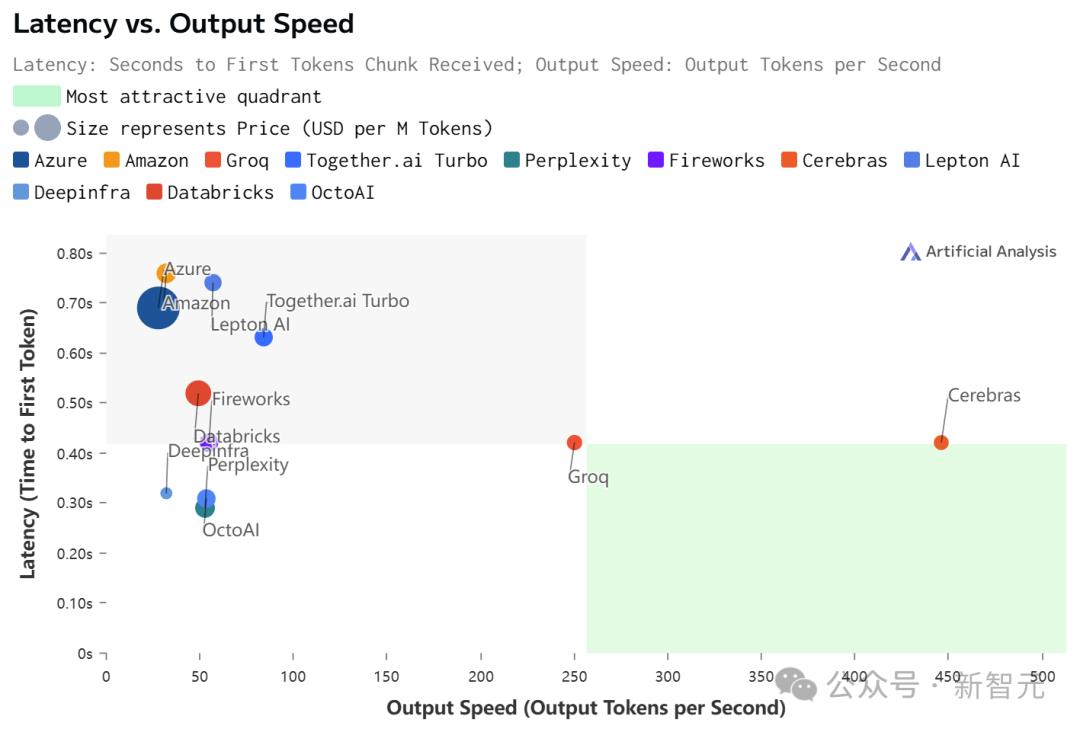

虽然在价格和延迟上,Cerebras都不是最低的。

但极致的速度,确实为Cerebras带来了极致的速度-价格和速度-延迟比。

不过,值得注意的是,在Cerebras上跑的Llama 3.1,上下文只有8k……

相比之下,其他平台都是128K。

具体数据如下:

Llama 3.1 70B

Llama 3.1 8B

参考资料:

https://cerebras.ai/blog/introducing-cerebras-inference-ai-at-instant-speed

https://x.com/CerebrasSystems/status/1828464491677524311

https://artificialanalysis.ai/models/llama-3-1-instruct-70b/providers

大家都在看

-

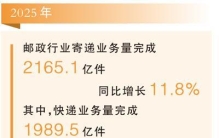

从世界最大寄递网络看活力中国(读数·年度数据深一度) 数据来源:国家邮政局搭乘“车厘子快线”,仅需25小时,满载百吨鲜果的全货机就能从智利飞抵湖北鄂州花湖国际机场,再借助公铁空立体化运力,快速直达全国各地。今年初,不少网友感叹:“年货办出了中国速度!”这只 ... 世界最大01-28

-

风云三号图像监测:曾经世界最大的冰山或将在几周内瓦解 记者从中国气象局获悉,风云三号D星最新传回的真彩色图像显示,曾经的世界最大冰山A23a主体面积仅余503平方公里,不足其最初规模的八分之一。而就在几周前,该冰山主体尚有948平方公里。从1986年脱离南极冰架时的417 ... 世界最大01-24

-

美国已经保不住日本了,俄罗斯通告了全球:中国是最大海军强国 俄罗斯专家直言中国海军已成全球最大规模力量俄媒报道,莫斯科国立大学亚非学院院长阿列克谢·马斯洛夫曾公开表示,中国水面舰队规模已经超过美国,中国按计划成为最大的海军强国。这番话直接点明当前海上力量对比变 ... 世界最大01-23

-

世界最大冰山有多“大”?面积堪比一国,水量相当于长江一年径流 (全城探秘所有原创首发文章,抄袭洗稿必究!)近段时间,A23a冰山引起了很多关注,根据我国风云三号D星1月14日传回的250米级分辨率真彩色图像显示,这座冰山的主体面积目前大约为506平方公里;我国风云三号D星拍摄 ... 世界最大01-21

-

中国经济将继续是全球经济增长最大引擎(权威论坛) 2025年,面对变乱交织的国际形势,中国经济运行总体平稳、稳中有进,高质量发展取得新成效,全年国内生产总值超140万亿元,比2024年增长5.0%。这份来之不易的成绩单,彰显了中国经济的内生韧性、创新动能。本期邀请6 ... 世界最大01-21

-

卫星影像记录:曾经的世界最大冰山,几周内崩解!原因为何? 距离南乔治亚岛以西约250公里,南纬52.75°、西经41.34°的寒冷海域,一场持续近四十年的冰山演变历程,正在这里迎来尾声。1月14日,风云三号D星传回250米级分辨率的真彩色图像显示,曾经的世界最大冰山A23a主体面积 ... 世界最大01-19

-

世界上最大的一块无主领土,日本早已开始布局,面积比我国还大 南极洲这地方,坐落在地球最南端,总面积有1400多万平方公里,比咱们国家的960万平方公里国土大出一截。整个大陆几乎全被厚厚的冰层裹着,平均厚度达到1900米,最厚的地方能到4000米。那里气候极端,冬天平均零下60 ... 世界最大01-17

-

世界最大,顺利始发! 1月13日,在郑和万里远航的起锚地江苏太仓,我国自主研制的世界最大直径竖井掘进机“启明号”正式始发,投入崇太长江隧道2号竖井建设,开创了我国高速铁路竖井采用掘进机施工的新纪元,也为迎接已突破万米掘进大关的 ... 世界最大01-15

-

世界最大开挖直径竖井掘进机今天始发 今天(1月13日)上午,我国自主研制的世界最大开挖直径竖井掘进机“启明号”在江苏太仓始发,用于崇太长江隧道的竖井施工,为隧道全线贯通奠定坚实基础。“启明号”竖井掘进机开挖直径达24米,主机高约13米。从空中 ... 世界最大01-14

-

特朗普抢资源抢土地!为美建立世界最大帝国 文︱柳扶风美国总统特朗普正在下一盘大棋,动用各种非法和残暴手段,为美国建立一个前所未有的世界大帝国。古往今来,大凡大帝国都要有最大的版图和土地,这是大帝国最重要的基础性资源和条件,有土斯有财,有土斯养 ... 世界最大01-12

相关文章

- 世界上最大的一块无主领土,日本早已开始布局,面积比我国还大

- 全球最大!这个“巨无霸”,来自舟山!

- 世界最大,顺利始发!

- 世界最大开挖直径竖井掘进机今天始发

- 特朗普抢资源抢土地!为美建立世界最大帝国

- 手握全球最大石油储量,委内瑞拉混得不如自家两位首富?

- 当世界最大债权国开始收账,谁会第一个垮塌?

- 35毫米!河南医生用3D打印成功封堵这项“世界最大”

- 入选2025央企十大超级工程!世界最大“清洁火电心脏”四川造

- 核战一旦爆发谁能挡得住?世界顶级强国背后博弈从未停止

- 我国建成世界规模最大教育资源中心

- “若中国成世界老大,美国必将视印度为最大敌人”

- 世界最大直径水下盾构隧道车道板施工突破3000米!

- 为何苏丹冲突酿成全球最大人道主义灾难?

- 昼夜吞吐量52698吨刷新世界纪录!山东港口青岛港:全球最大纸浆进口港再展“中国效率”

- 世界上最大的海“珊瑚海”究竟有多大?

- 全球最大!我国首个百万千瓦级海上光伏项目全容量并网

- 世界最大跨度三塔钢箱梁斜拉桥双主塔封顶

- 福岛核灾15年阴影未散,日本仍要重启世界最大核电站,争议拉满

- 昆虫界的“巨无霸”:盘点世界上最大的十种昆虫

热门阅读

-

泷泽萝拉作品,光看一眼就让人欲罢不能 07-14

-

高岗事件真相令人震惊 究竟有何隐秘内幕 07-14

-

北京大裤衩 也就是中央电视台总部大楼 10-24

-

江户四十八手 看一看可以年轻十岁 11-01

-

柳州莫菁视频流出,最终判定是男友所为触及法律底线 11-14

-

揭秘翁帆怀孕真相 杨振宁和翁帆的孩子 11-15

-

世界上最大的火车站,在中国(100个足球场大) 05-26